一 : SEO优化经验:nofollow标签使用的一点启发

“百度百科”您知道吗?不知道,那您OUT了。利用“百度百科”做外链,您会吗?不会,那您也OUT了。“百度百科外链”可谓是“外链建设方法”中无人不提及、无人不提倡的高权重外链形式。

如果您相信了以上的话。那么,今天,小鱼儿告诉您:您还是OUT了。因为您并没有发现“百度百科”的变化;平时没有注重对外链的效果和方法进行认真查看与总结。

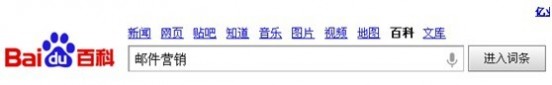

小鱼儿最近在运营一个做邮件营销的企业网站,一直在关注并修改整理了“邮件营销”这个百度百科词条。

功夫不负有心人,终于在2013.7.10带上了网站的链接,略带欣喜啊~!(如下图)

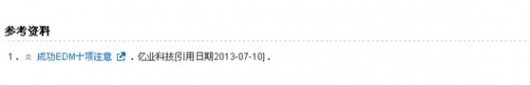

2013.8.1“邮件营销”词条收录更新了(如下图)

暗自高兴的小鱼儿觉得做了一个高权重的外链。可是,通过多方外链查询工具,并未查询到此条外链,小鱼儿感觉有点奇怪。于是,打开了“邮件营销”百科词条的源代码,这叫一个坑爹啊!真是坑了无数seoer啊!

百度这家伙的“百度百科”竟然给辛勤的编辑者留得链接加了“nofollow标签”,百度啊!人工审核!链接还给加“nofollow标签”真不厚道!

都说“seo要学会从日常观察和积累中总结优化知识”,小鱼儿就就今天无法改变的“nofollow”事实,与大家分享一下“nofollow标签使用的一点启发”

“nofollow 标签”是Google、Yahoo和微软公司前几年一起提出的一个标签,链接加上这个标签后就不会被计算权值,搜索引擎支持nofollow属性:大致的意思就是A页面链接到B页面,如果此链接加了nofollow属性,那么A页面的权重不会流向给B页面。

1.站内合理的使用“nofollow标签”防止权重的流失

通常我们所运营的网站,可能会出现一些并不希望但却存在的外部链接,比如:博客、论坛的一些评论外部链接;网站给商家做广告的链接、、、这时候我们就可以通过nofollow标签来保障自己的网站权重不被流失。

2.合理的使用“nofollow标签”让不必要的页面不分配网站权重

在做网站的时候,我们通常会把网站的服务,产品信息等重要页面通过主导航体现。而一些“关于我们、网站发展、网站介绍”等页面放在页脚导航。但是,很多人忽略了,其实一些固定的网站介绍并不会给网站的排名起到作用,但它却在整个网站中存在。所以我们有必要在这时候通过“nofollow标签”防止权重流失到这些不影响排名的页面。

3.“nofollow标签”的外链不会给网站带来权重

很多外部平台为了保证自身权重的不流失,往往通过“nofollow标签”来保障自己的利益。这时候,如果您想通过外部链接提供自身网站的权重,您就需要选择性的来发送。

SEO不能一层不变,时代在变,搜索引擎在变,我们要学会去改变,学会去观察,也许你今天认为正确的方法,在明天也许就改变了。SEO要学会注重在细节上,这样我们才能在亚历山大中需求自己合理的定位。

本文由邮件营销服务商“亿业科技”http://www.easeye.com.cn/原创在站长网首发,转载请注明出处。谢谢!

注:相关网站建设技巧阅读请移步到建站教程频道。

二 : 怎么利用robots文件做好网站优化让蜘蛛更好的抓取网站?

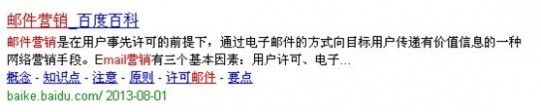

robots文件存在于网站根目录,是用来告诉百度蜘蛛那些应该抓取,那些不应该抓取。正确使用robots文件有助于做好seo优化,robots文件的核心词汇就是allow和disallow用法。百度官网是认可这个文件的,在百度站长平台上也有robots这个栏目,点击进入,就可以看到你网站robots文件是否编写正确了。

百度robots文件使用说明

1、robots.txt可以告诉百度您网站的哪些页面可以被抓取,哪些页面不可以被抓取。

2、您可以通过Robots工具来创建、校验、更新您的robots.txt文件,或查看您网站robots.txt文件在百度生效的情况。

3、Robots工具暂不支持https站点。

4、Robots工具目前支持48k的文件内容检测,请保证您的robots.txt文件不要过大,目录最长不超过250个字符。

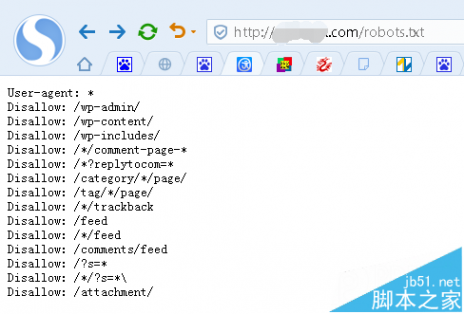

上图我给的一个例子中,disallow语句有问题,原因是把英文的冒号写成了中文的冒号。

当然直接输入网站根目录加上robtots.txt文件也可以

User-agent:* 是用来置顶那些搜索引擎蜘蛛可以抓取的,一般默认设置

Disallow:/category/*/page/ 分类目录下面翻页后的链接,比如,进入校赚网分类目录 "推广运营经验"目录后,在翻页一次,就成了 stcash.com/category/tuiguangyunying/page/2形式了

Disallow:/?s=* Disallow:/*/?s=* 搜索结果页面和分类目录搜索结果页面,这里没必要再次抓取。

Disallow:/wp-admin/ Disallow:/wp-content/ Disallow:/wp-includes/ 这三个目录是系统目录,一般都是屏蔽蜘蛛抓取

Disallow:/*/trackback trackback的链接

Disallow:/feed Disallow:/*/feed Disallow:/comments/feed 订阅链接

Disallow:/?p=* 文章短链接,会自动301跳转到长连接

例如,朱海涛博客之前就被收录过短连接

Disallow:/*/comment-page-* Disallow:/*?replytocom* 这两个我在之前文章有过说明,来自于评论链接,很容易造成重复收录。

在robots.txt文件的最后还可以制定sitemap文件 Sitemap:http://***.com/sitemap.txt

sitemap地址指令,主流是txt和xml格式。在这里分享一段张戈所写txt格式的simemap文件。

将上述代码保存到txt文件,上传到根目录,并且在robots.txt文件中指定即可

这里给大家共享下我的robots.txt文件

复制内容到剪贴板

三 : 网站优化必看 蜘蛛陷阱 不利于蜘蛛爬取的网页

1、搜索引擎能不能找到网页。

1)要让搜搜引擎发现网站首页,网站推广就必须有良好的外部链接链接到首页,就找到了首页,然后蜘蛛会沿着链接爬的更深。

让蜘蛛通过简单的html页面的链接到达,javascript链接,flash链接都是蜘蛛的陷阱。这点要注意。

2)找到网页后能不能抓去内容。

被发现的蜘蛛是可以被爬取的,数据库动态生成,带过很多的参数url、sessionID、整个页面都是flash、框架结构、大量的转向,和大量的复制内容都可能把蜘蛛拦截在门外。这也也是要注意的

2、flash

1)在网页某一个部分使用flash来增强视觉效果很正常网络推广,比如现在很多的flash广告、图标等。但是这是一个html页面的一部分。不会有太大的影响

2)但是有的网站就是一个很大的flash文件,这就构成了蜘蛛的陷阱,这时候蜘蛛爬取的只有一个flash链接,没有其他的内容,所以这点尽量要避免。

3、sessionID

1)有些网站使用sessionID(会话ID)跟踪用户的访问,用户的没一次访问都会生成一个独立的ID,然后加在url里,这是蜘蛛每一次抓取网站都会把蜘蛛当作一个新的用户网络营销,造成蜘蛛不能正常爬取,这也是蜘蛛的一大陷阱。

2)通常建议跟踪用户访问应该使用cookies而不要生存sessionID 。

4、各种的跳转

1)除了大家熟悉的301转向之外,其他的转向对搜索蜘蛛都比较敏感的,比如302暂时转向,javascript转向,flash转向,meta refresh跳转,所以建议大家不要做其他不利于网页的转向,301也包括,不到万不得已的时候也不要用301转向。这是个建议。谢谢阅读,希望能帮到大家,请继续关注61阅读,我们会努力分享更多优秀的文章。

四 : SEO优化 蜘蛛的爬行规则以及让蜘蛛爬行的快速办法

一、蜘蛛的脾性

蜘蛛是一个拥有一定程序的机器人,但是我们却做不到十分了解蜘蛛最喜欢的是什么?所以这让很多站长们很头疼,其实要想和蜘蛛打好关系,只要知道它们喜欢什么就可以了,因为蜘蛛是机器人,所以在它们的眼里所有的规矩都是定死的,所以就不会像人一样用饭局烟酒来打关系,所以只要了解蜘蛛的脾性就可以有方法与蜘蛛打好关系,当蜘蛛爬行一个网站的时候,它需要爬行的信息首先就是站内的结构,查看站内结构是否是安全的,如果有危险性的话蜘蛛是不会对其网站爬行的,一般蜘蛛识别网站不安全的是**站,因为**站容易生成死循环,如果蜘蛛掉进死循环也就是我们所说的蜘蛛陷阱的话就很难再爬行出来。

所以如果一个网站有危险性,蜘蛛是不会对其网站爬行的,当蜘蛛爬行网站看完结构辨认是安全的话,那么它下面要做的就是对站内信息的收录,蜘蛛辨认站内信息收录的主要因素是创新的,原创的,如果说你的页面上面全部是图片、 Flash等蜘蛛无法辨认的东西,那么蜘蛛是不会收录信息的,大家要记住蜘蛛只收文字信息,图片信息等蜘蛛是无法识别的,当蜘蛛辨认文章是创新的而且是原创,那么蜘蛛就会把信息带到服务器,然后服务器整合以后看文章的价值,然后做排名处理,其实蜘蛛爬行的时候就这么简单,所以只要我们知道它在爬行的时候有什么样的习惯和脾性,那么我们让蜘蛛喜欢自己的网站也是很容易的,所以不要觉得吸引蜘蛛有多么难,其实这一切就这么简单,下面我给大家总结蜘蛛主要喜欢的东西。

1、安全的静态网站是蜘蛛最喜欢的,**站有时蜘蛛可能不会收录其中的文字信息。

2、蜘蛛喜欢原创文章,如果文章在服务器上有重复的,蜘蛛就不会对其收录的如这个站不收录了。

3、蜘蛛喜欢站内明确的表明关键词、权重网页等信息,明确这些不会误导蜘蛛。

4、蜘蛛喜欢定点来访,所以蜘蛛一般都会每天固定时间段对网站进行爬行。

二、如何让蜘蛛对自己网站爬行

当我们知道了蜘蛛的喜好之后,下面就要逐步迎合蜘蛛的日常生活了,所以我们要做的就是蜘蛛喜欢的事情。

我们首先让蜘蛛知道自己的网站的话,那么最好的办法就是写高质量的软文,软文不仅是高质量的外链,也是引导蜘蛛对自己网站爬行的一种方法,当我们写好软文后发到一些高质量的原创网站上去,因为原创网站的权重都比较高,所以蜘蛛是每天都会去的,所以当蜘蛛爬行到你的文章后发现里面的连接地址后,顺这就对你的网站进行爬行了,所以说当蜘蛛尽到我们的网站后一定要符合蜘蛛所喜欢的格式,只有这样蜘蛛才会喜欢上自己的网站,就像我上面所说的,蜘蛛喜欢安全的网站,所以本人建议做静态网站,当蜘蛛看完网站是安全后就会对你的站内文章进行爬行了。

说到这里我要说几句,其实有很多站长很喜欢用为原创工具进行伪原创,因为自己写原创很浪费时间,其实本人不建议使用伪原创工具,因为现在蜘蛛们已经很智能了,它们有它们自己的算法,然后按照算法识别你的文章是否用机器伪原创了,如果有的话,蜘蛛是照样不会收录你的文章的,所以本人建议当我们更新文章的时候,可以找一些文章,然后用自己的语言进行描述一遍,这样蜘蛛就无法识别了,因为自己手动伪原创的文章可读性比较高,所以蜘蛛会以为你的文章是原创文章,当蜘蛛爬行你的文章后就会带到服务器然后进行收录。

五 : 网站SEO从业者一定要懂得利用链接助力优化

下面,笔者就与大家分享一下关于链接使用的一些注意点:61阅读| 精彩专题| 最新文章| 热门文章| 苏ICP备13036349号-1